Robots.txt er en lille fil, der ligger på din hjemmeside, hvor du kan fortælle diverse robotter, hvad de må og ikke må på din side. Det første en robot gør, når den crawler din side, er at tjekke, om du har en robots.txt liggende på dit hjemmeside.

Fem hurtige om robots.txt

- robots.txt skal ligge i roden af din hjemmeside. Det vil sige, der hvor alle dine hjemmeside filer ligger.

- robots.txt er case-sensitive. Den skal altså hedde “robots.txt” helt præcist.

- robots.txt er offentlig tilgængelig for alle. Du skriver bare /robots.txt efter en adresse. Du kan jo prøve at skrive aveo.dk/robots.txt og se, hvad der sker.

- Har du underdomæner, så skal de alle sammen have en separat robots.txt fil, hvis du skal bruge den.

- Det er en god idé at smide dit/dine sitemap(s) ind i denne txt fil med følgende syntaks: Sitemap: “sitemap “url”” – Eksempel: Sitemap: https://aveo.dk/sitemap_index.xml

OBS: Hvis du ikke har behov for at blokere for adgangen til dit site for nogle robotter, så har du IKKE brug for en robots.txt fil.

Sådan fungerer robots.txt

Når det kommer til at forstå robots.txt-filer, er det vigtigt at kigge på, hvordan de er skrevet. For bedst at kunne styre søgemaskinernes adgang, skal du kende til de her fem direktiver:

- User-agent: Her går du ind og definerer, hvilken robot du giver crawl instruktioner til. Det er for det meste søgemaskiner, men det kan også være SEO-værktøjer, der crawler din side.

- Allow: Dette er kommandoen, hvor du bestemmer, hvad robotten må besøge. Det bruges til at fortælle, at de godt må besøge nogle undermapper, selvom hovedmappen måske er forbudt.

- Disallow: Den modsatte af Allow og bestemmer altså, hvad robotterne ikke må.

- Crawl-delay: Denne kommando fortæller robotten, hvor lang tid den skal vente med at loade og crawle din side.

- Sitemap: Som nævnt ovenover, så er det til at vise robotterne, hvor dine/dit sitemap(s) er placeret. Denne kommando er, pr dags dato, kun supporteret af Google, Ask, Bing og Yahoo.

En hel basis template kunne være:

User-agent: [user-agent navn]

Disallow: [Det der ikke skal crawles]

Hvordan laver du en robots.txt?

Det er en forholdsvis simpel proces at lave en robot.txt. Først skal du bruge et simpelt tekstredigeringsprogram, det kan eksempelvis være Notepad, hvis du har en Windows-computer eller TextEdit på Mac. Her skal du skrive de regler, du ønsker at anvende.

Det kan eksempelvis være, hvis der er mapper eller sider, som skal udelukkes for crawling. Når du har skrevet dine regler ind, skal du gemme filen som ‘’robots.txt’’.

Det er vigtigt, at filnavnet er skrevet i små bogstaver, og dermed kan du sikre, at webcrawleren kan genkende og følge filen korrekt. Hvis du ønsker mere information, har Google lavet en guide.

Når din robots.txt-fil er klar, skal den uploades til rodmappen på din webserver. Dette er i den øverste del af din hjemmeside, hvor hjemmesidens hovedside findes, altså index.html eller index.php. Ved at placere filen her sikrer du, at webcrawleren nemt kan finde og læse de regler, du har sat for din hjemmeside, inden de crawler det hele.Du kan teste, om robots.txt er placeret og fungerer korrekt, ved hjælp fra dette værktøj.

Hvorfor skulle du have brug for at spærre for robotter?

De mest gængse grunde til at skulle blokere for robotter er for at undgå duplikeret indhold eller blokere for eksempelvis PDF filer, som du alligevel ikke vil have ud på Google.

Pas dog på med, hvad du gør. Er du ikke særlig teknisk kyndig, eller er du usikker på, hvad du laver, så få andre til at kigge på det. Det kan være MEGET skadeligt at komme til at blokere for søgemaskinerne på hele dit website

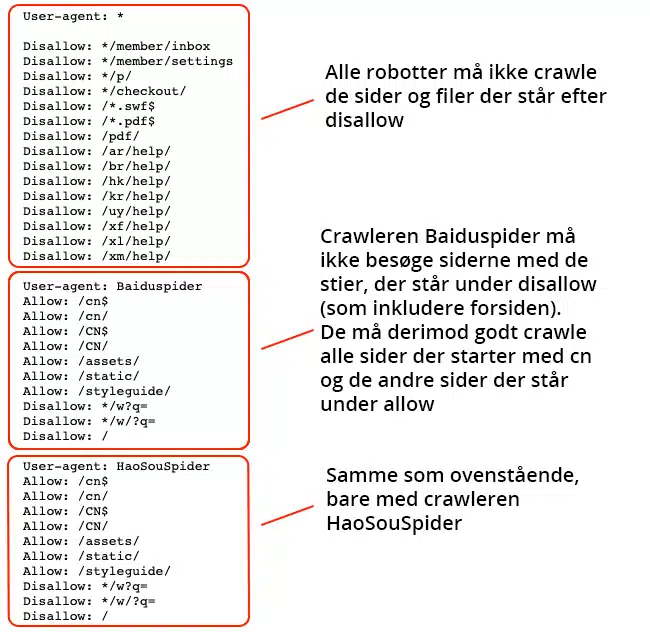

Eksempler på spærringer

Det er ikke sikkert, at du nogensinde kommer til at skulle bruge denne robots.txt, men vi har her samlet en del basale eksempler på, hvordan sådan en fil kan se ud, når man vil have blokeret eller på anden måde fortalt robotterne, hvad de må.

Bloker alle robotter fra alt indhold

User-agent: *

Disallow: /

Giv adgang til alt indhold (den mest almindelige, hvis har fået genereret en robots.txt)

User-agent: *

Disallow: /

Bloker Googles robot fra en underside

User-agent: Googlebot

Disallow: /blokeret-side/

Bloker Bings robot fra en mappe

User-agent: Bingbot

Disallow: /specifik-undermappe/

Bloker alle pdf filer fra at blive vist

User-agent: *

Disallow: /*.pdf$

FAQ

Hvad sker der, hvis jeg ikke har en robots.txt-fil?

Hvis dit website ikke har en robots.txt-fil, vil søgemaskinernes crawlere forsøge at indeksere alt de kan få adgang til. Dette er ikke nødvendigvis dårligt, men det kan føre til, at mindre relevante sider bruger op crawlbudgettet, hvilket kan påvirke, hvor effektivt og hurtigt dine vigtigste sider bliver indekseret.

Kan jeg bruge robots.txt til at skjule følsomme oplysninger eller sider?

Nej, det er en almindelig misforståelse. At nævne en side i robots.txt som “Disallow” gør faktisk opmærksom på siden og forhindrer ikke adgang til den. Følsomme oplysninger bør beskyttes med andre metoder, såsom adgangskodebeskyttelse eller ved at placere dem bag en sikker firewall.

Skal jeg oprette en robots.txt-fil for mit lille website?

Selv for små websites kan en robots.txt-fil være nyttig. Den kan hjælpe med at styre, hvilke dele af dit site der bliver indekseret, og sikre, at søgemaskinernes crawlers bruger deres tid og dit websites ressourcer mest effektivt.

Hvad sker der, hvis der er konflikter mellem `Allow` og `Disallow` direktiver i min robots.txt-fil?

Søgemaskinernes crawlers følger generelt princippet om, at det mest specifikke direktiv har forrang. Hvis der er en konflikt mellem `Allow` og `Disallow` direktiver for den samme URL, vil de fleste crawlers prioritere det direktiv, der er mest specifikt defineret. Det er dog god praksis at undgå sådanne konflikter for at sikre klar kommunikation af dine intentioner til crawlers.